微云全息(NASDAQ: HOLO)发布对抗性攻击防御新框架:机器学习系统的安全关键分析

- 2025-06-18 22:01:01

- 超级管理员

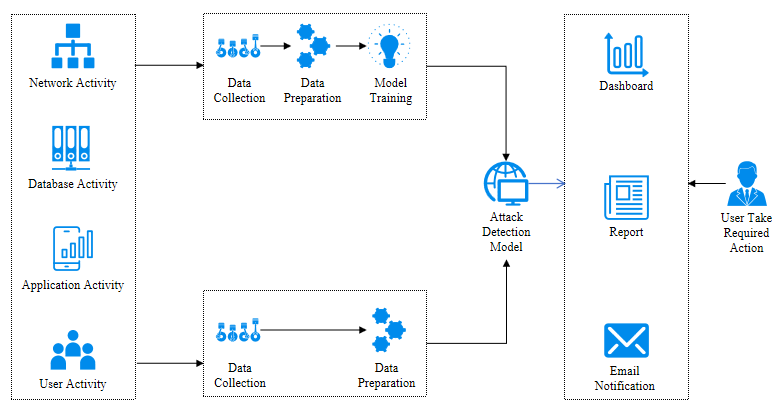

在人工智能(AI)技术飞速发展的今天,机器学习模型的安全问题日益受到关注。微云全息(NASDAQ: HOLO)最新研究显示,对抗性攻击对机器学习系统的威胁不容忽视。这些攻击能够使模型“中毒”,逃避分类,甚至泄露关于模型和训练数据的敏感信息。微云全息通过深入分析,提出了一种新的框架,称为SARS 框架(Secure AI Robustness System),旨在从安全关键的角度出发,评估和增强机器学习系统的安全性。

对抗性攻击是指通过精心设计的输入,误导机器学习模型做出错误判断的攻击方式。这些攻击不仅威胁到模型的准确性,更可能对依赖这些模型的实时和安全关键系统造成严重后果。微云全息的研究指出,尽管已经提出了多种防御措施,但它们往往在计算上成本高昂,且可能降低模型的性能。为了解决这一问题,微云全息提出了一种SARS 框架。该框架使用对抗性噪声来评估机器学习系统的安全性,从而找到系统可能失败的上限。这种方法不仅简单实用,而且能够有效地平衡鲁棒性和准确性之间的反比关系。

在对ResNet架构进行的测试中,微云全息发现,即使是在小规模的基准数据上,所有的测试配置也无法满足“安全关键”的任何合理定义。这一发现表明,现有的机器学习系统在安全性方面还有很大的提升空间。且,安全关键系统受到法律约束,要求软件更改必须是可解释的,并且每一个更改都必须经过彻底的测试。这为机器学习系统的开发和维护带来了新的挑战。

SARS 框架旨在帮助开发者更好地理解和控制这些更改,以确保系统的安全性和合规性:

安全性评估(Security Assessment)

对抗性噪声生成:利用先进的算法生成对抗性噪声,模拟潜在的攻击场景。

系统响应分析:评估机器学习系统在对抗性噪声输入下的反应,确定系统的脆弱性。

鲁棒性增强(Robustness Enhancement)

模型加固:通过对抗性训练,增强模型对噪声的抵抗力,减少误判率。

数据清洗:开发算法清洗训练数据中的潜在噪声,提高数据质量。

准确性保障(Accuracy Assurance)

性能基准测试:建立性能基准,确保在增强鲁棒性的同时,模型的准确性不会受到太大影响。

实时监控:部署实时监控系统,持续跟踪模型的表现,及时发现并解决性能下降问题。

法律合规性(Legal Compliance)

可解释性设计:确保所有模型更改都是可解释的,以满足法律对透明度的要求。

合规性测试:对模型更改进行严格的合规性测试,确保符合所有相关法律法规。

系统整合(System Integration)

框架集成:将SARS框架集成到现有的机器学习系统中,提供全面的安全和性能保障。

用户培训:对用户进行培训,使其了解如何使用SARS框架,以及如何解读和应用安全分析结果。

持续改进(Continuous Improvement)

反馈循环:建立反馈机制,收集用户和系统的反馈,不断优化SARS框架。

研究合作:研究新的安全威胁和防御策略,保持SARS框架的前沿性。

透明度和信任(Transparency and Trust)

透明度报告:定期发布透明度报告,公开SARS框架的安全性评估结果和改进措施。

社区参与:通过开放源代码和协作开发,增强框架的可靠性和信任度。

微云全息(NASDAQ: HOLO)的SARS框架旨在为机器学习系统提供一个全面的安全解决方案,确保在提高鲁棒性的同时,不会牺牲模型的准确性,并且满足法律合规性的要求。通过不断的技术迭代和社区合作,SARS框架将能够适应不断变化的安全威胁,为生产级人工智能系统的安全提供坚实的保障。